2023年06月28日 13:48供稿中心:北大青鸟总部

自大数据的概念被提出以来,企业对于数据信息变为数据资产的诉求越来越强烈,进而在技术领域出现了很多大数据计算引擎服务,最著名、使用最广的莫过于MapReduce、Storm、Spark、Sparkstreaming、Flink了。它们都是在不同的时代背景下所产生的,又是为了解决每个阶段所不能遇到的难题而新出现的解决方案,那么它们到底是什么呢?我们今天一一的来看看这些计算引擎宝贝们~

从处理的时间来看,我们可以把大数据计算引擎划分为离线计算、实时计算两类,离线计算一般是T+1的延迟,实时计算一般是秒级或毫秒级的延迟;从处理的数据量来看,我们可以把大数据引擎划分为流式计算、批量计算两类,流式计算是一次来一条处理一条,批量计算则是一次来多条处理多条。MapReduce、Spark属于离线计算、批量计算引擎,Storm、Sparkstreaming、Flink属于实时计算、流式与批量并存的计算引擎。

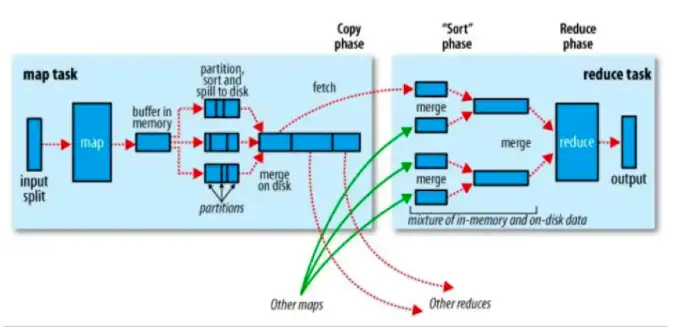

给计算引擎宝贝们分好类之后,我们一个个的来看看它们的绝技。MapReduce是大数据计算引擎的开山鼻祖,自Google著名的三篇论文发表之后,大数据处理开始流行起来,很多企业都使用Hadoop三件套MapReduce、HDFS、YARN来进行大数据的处理任务,所有的数据在进行处理前会划分成大小相同的数据,经过Map模型初次处理数据,得到中间结果,再经过Reduce模型二次处理中间结果数据,最后得到分析数据,存储在HDFS。在该模型中,存在两个问题:

1、模型简单,对于复杂的处理任务不好支持。对于复杂的统计分析任务,在MR模型中就需要经过多次转换成中间结果,尤其是人工智能、深度学习类需要多次计算的场景就更不好使了;

2、不能有效的利用内存,在MR模型中所生成的中间数据都是存储在磁盘中的,每次数据进入磁盘,再从磁盘读取出来,非常的耗费IO,时间延迟太长了。因此Spark出现了。

Spark是升级版的MapReduce计算引擎,在Spark中引入了RDD弹性分布式数据集(ResilientDistributedDatasets),在Spark中多个计算任务可以并在1个RDD里进行,假设我们的数据是存储在HDFS当中,当要进行数据处理时,我们先把数据划分成为多个大小相同的数据,一组任务是一个Stage,在Stage1阶段进行Map计算,产生中间结果(RDD1),在Stage2阶段进行Reduce计算,产生中间结果(RDD2),在Stage3阶段再将之前阶段的结果关联起来(RDD3),最后给到Actions将RDD计算结果给到业务呈现。

在Spark模型中,它支持复杂的计算模型(支持多个Stage),也优化了磁盘性能问题(每个数据集任务都被抽象成RDD进行计算,存储在内存中),以至于有人说Spark会取代MapReduce。在Spark模型流行了一段时间后,互联网企业们对于数据的要求变得越来越高了,他们希望更快的得到数据分析结果,所以实时计算应运而生。

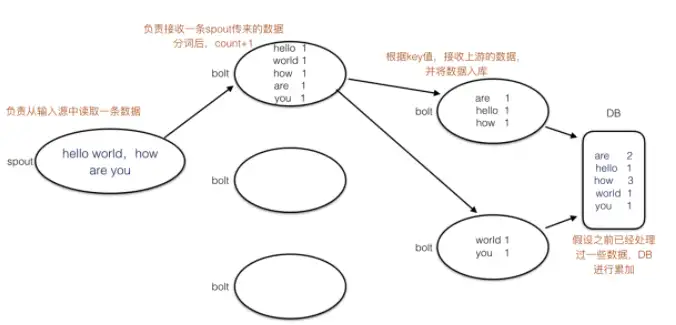

最先出现的实时计算框架是Storm,在Storm中有spout管口、bolt处理器、tuple元组的概念,spout负责从数据源接收数据tuple,按照一定的规则下放给到bolt进行处理,处理结束之后由数据库存储相应的结果。Storm处理模型中存在高可用和数据准确性问题,所谓高可用指的是spout节点挂掉了,数据计算任务怎么办?

在MapReduce中数据挂掉了之后会重启Map模型,而在Storm中也有一个对应的ACK机制,bolt接收到数据之后返回确认,处理完数据后返回确认,数据库存储数据后返回确认,基本要三轮确认后整个处理任务才算完成了;所谓准确性指的是数据重复处理问题,比如在数据处理过程中,处理节点bolt1处理完数据之后,发送给了接收节点bolt1,但接收节点bolt1还没来得及确认,处理节点bolt1挂掉了,处理节点bolt2继续重复处理bolt1的数据,从而导致在整个任务中数据是有冗余的。在Sparkstreaming中针对这两个问题,提出了对应的解决方案。

Sparkstreaming是Spark的升级版本,在Sparkstreaming使用RDD模型将每次处理的数据转换成1个数据集进行处理,减少了每次ACK的开销,提高了效率,并通过exactlyone精准消费一次模型来保障数据的重复处理问题。它联同分布式消息队列Kafka(生产者消费者使用事务ACID模型来保障了数据消费和更新的原子性)在消息发送处、消息接收处实现了exactlyone。在Sparkstreaming中存在的问题是每次处理的数据量都是小批量的,如果我们想实现更小颗粒度的数据处理,就没有办法了,但这时候Flink应运而生。

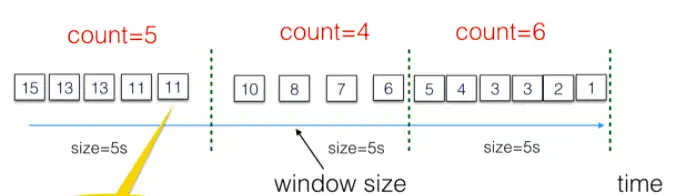

Flink通过分布式快照snapshot快照模型来实现数据按条处理,在整个数据处理任务当中,snapshot快照模型对每次操作都进行拍照,记录当时处理现况,当处理发生故障时,Flink则停止当下处理,找到最近一次快照,把数据流恢复到当时的处理节点,让业务按照当时处理情况继续处理。并且为了更高效的处理任务,Flink还提供了Window窗口模型,支持用户自定义每个窗口需要处理的数据或时长。

在本文介绍了MapReduce、Storm、Spark、Sparkstreaming、Flink五款大数据计算引擎如何处理大数据计算任务,各自的特点,所解决的问题,其实并不是说能解决最多问题的就是最好的,在采用大数据计算引擎之前,应当结合自己的业务特点、数据诉求,综合开发成本、维护成本,再决定采用哪一款,最合适的才是最强的。

提交成功,感谢您的反馈。

我们会认真阅读和考虑每个用户的反馈。